Perioada în care trăim este una caracterizată de imensul avans tehnologic ce aduce, deopotrivă, beneficii și inconveniente. Unul dintre aspectele pozitive este remarcat în practica directă cu analiza de date. Elemente ce țin de procesare, stocare, vizualizare, sunt doar câteva îmbunătățiri tehnice ce vin în sprijinul lucrului cu datele.

Acesta este subiectul ce îl voi detalia în continuare.

Dacă ar fi să imaginez un scurt scenariu, în care să explic rolul unui specialist în domeniul datelor aș zice că este asemeni unui detectiv care caută adevărul: informații și cunoștințe care să explice, să rezolve o situație aparte. În acest scop, se folosește de o serie de metode și metodologii, puse într-o ordine strategică.

Despre Date, date, DATE

Cuvântul date provine din latinescul datum și înseamnă „cadou” , „lucru dat” . Cu o importantă semnificație, zic eu, deoarece fără date nu există, cu adevărat, o analiză și, respectiv, o concluzie care să permită cunoașterea unui fenomen.

Mergând mai departe, pot fi privite ca un dar care te ajută efectiv în activitatea pe care dorești să o realizezi: fie prin prisma luării unei decizii eficiente, fie a construirii unui model care să prezică costurile pentru o afacere etc. Singura condiție este să știi cum să le folosești (să le citești, să vezi ce transmit – metaforic vorbind).

Cine generează aceste date? Evenimentele de zi cu zi, indiferent de domeniu (de exemplu: medicină, informatică, biologie etc.). Persoanele care sunt infectate și urmează un anume tratament, rețelele de socializare, inundațiile dintr-un colț de lume, operațiunile de comerț online, interacțiuni realtime de pe terenul sportiv, de joc etc. Cantități enorme de date – big data – care sunt caracterizate de viteza, volumul și diversitatea cu care își fac simțită prezența în spațiul cercetărilor. Pentru a le analiza cu ușurință se aduc împreună metode din statistică, din data mining și computer science.

Un procedeu de analiză

Un procedeu des întâlnit în analiza de date este cel cu referire la procesul KDD (Knowledge Discovery in Databases) – literal, Descoperirea Cunoștințelor în Baze de Date. Reprezintă o succesiune de etape. Voi aminti câteva detalii care să completeze cele spuse.

Etapa #1 Înțegerea domeniului și găsirea unor obiective de lucru

Mă documentez cu privire la domeniul ales spre studiere, la fenomenele specifice, identific problema/situația de rezolvat și stabilesc acele obiective de lucru.

Etapa #2 Selectez și adaug date

Este momentul să culeg date și să le integrez într-un suport electronic. Cel mai comun este o baza de date, un data warehouse sau simple foi de înregistrări precum documentele excel, csv.

Etapa #3 Preprocesare date

Fac acțiuni de curățare și corectare a datelor, eliminare erori, data lipsă, outlieri. Este preponderent o analiză exploratorie și se foloseste de tehnicile din analiza statistică descriptivă. În general, această activitate ocupă cam 80% din timp. Datele alese trebuie să fie într-o formă concisă și să reflecte cu acuratețe fenomenul studiat, astfel încât și mesajul obținut din urma rulării unui algoritm să fie corect.

Etapa #4 Transformarea datelor

Pregătesc datele în forma necesară pentru aplicarea unui algoritm specific de data mining. Pot alege o variantă de machine learning supervizată și atunci am nevoie de o coloană care să reflecte, de pildă, o clasă de valori (de exemplu clasa Gender: Male/Female), care poate necesită o recodificare, sau o normalizare etc. Coloana – în sensul uzitat la forma tabelară de aranjare a datelor.

Etapa #5 Data Mining

Aplic efectiv algoritmul pe setul de date ales. Funcție de ceea ce doresc să obțin ( de exemplu: predicții, segmentări, clasificări ș.a) voi separa, de exemplu, datele inițiale in train (antrenare – 70%), testare(20%) și validare(10%).

Etapa #6 Evaluare și interpretare

În urma rulării algoritmului decid dacă este un bun model de predicție, să spunem. Mă folosesc de diferiți indicatori de calitate, interpretez matricea de confuzie etc. Dacă este acceptat merg la etapa următoare, dacă nu, revin chiar și din prima etapă și gândesc un alt fel de colectare a informațiilor care să mă conducă la un alt rezultat.

Etapa #7 Cunoștințele descoperite

Vizualizarea și integrarea cunoștințelor descoperite sunt pasul final care reprezintă succesul și bucuria aplicării acestui procedeu denumit KDD.

Tehnologii folosite în analiza datelor

Conform TIOBE Index pentru Mai 2024, Python (#1), Java (#4) și SQL (#9) sunt în top 10 popularitate a limbajelor de programare. Sunt puncte cheie și în analiza datelor, la diferite etape de implementare, alături și de alte tehnologii pe care nu le menționez (de exemplu Tableau, MySQL, AWS etc.).

Un motiv aparte pentru locul fruntaș pe care-l ocupă Python este dat și de facilitățile extinse pe care le oferă prin intermediul librăriilor disponibile și care se pretează la scopuri diverse:

Cum arată codul scris în limbajul de programare Python?

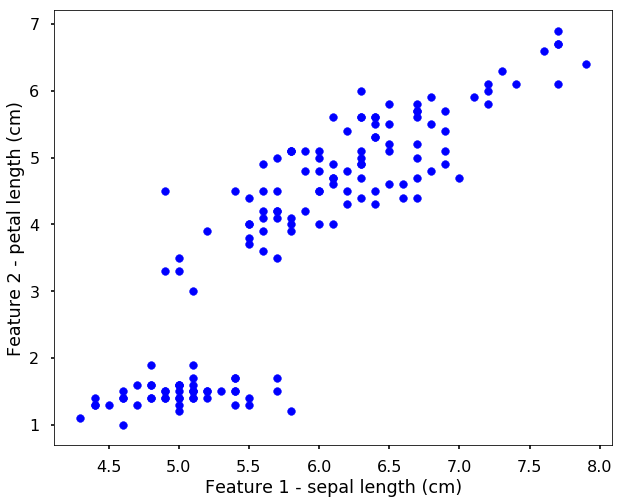

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

plt.style.use('seaborn-poster')

%matplotlib inline

# import the iris data

iris = datasets.load_iris()

# let's just use two features, so that we can

# easily visualize them

X = iris.data[:, [0, 2]]

y = iris.target

target_names = iris.target_names

feature_names = iris.feature_names

# get the classes

n_class = len(set(y))

# let's have a look of the data first

plt.figure(figsize = (10,8))

plt.scatter(X[:, 0], X[:, 1], \

color = 'b', marker = 'o', s = 60)

plt.xlabel('Feature 1 - ' + feature_names[0])

plt.ylabel('Feature 2 - ' + feature_names[2])

plt.show()

Pentru a continua să citești pe acest subiect, un bun start este cartea ÎN CULISELE BIG DATA. O abordare statistică scrisă de Rafael Lahoz-Beltra.

Ţi-a plăcut? Te invit: să distribui(share) sau să apreciezi(like) sau să comentezi(comment) postarea.

Îți mulţumesc, Zâmbetul Soarelui !

Lasă un comentariu